Gemini : un futur plus brillant pour la création et l’apprentissage

L’annonce récente de Gemini 2.5 Pro et Flash, avec leurs mises à jour et leurs capacités améliorées, n’est pas seulement une nouvelle étape ; c’est un bond en avant qui redéfinit ce que l’IA peut […]

Ce que vous allez découvrir

- Gemini 2.5 Pro : une puissance qui défie les attentes et redéfinit l'excellence

- Deep Think : quand l'IA pense profondément pour résoudre l'irrésoluble avec Gemini

- Flash 2.5 : L'alliance de la vitesse et de l'efficacité pour une IA aaccessible

- Des fonctionnalités révolutionnaires : Gemini 2.5 au service de l'humain

- Une expérience de développement améliorée : transparence et contrôle accrus

- Le futur de l'IA : un engagement continu vers l'innovation et la responsabilité

Gemini : un futur plus brillant pour la création et l’apprentissage

L’annonce récente de Gemini 2.5 Pro et Flash, avec leurs mises à jour et leurs capacités améliorées, n’est pas seulement une nouvelle étape ; c’est un bond en avant qui redéfinit ce que l’IA peut accomplir, ouvrant des horizons inédits pour les développeurs, les entreprises et, in fine, pour chacun d’entre nous. Ce n’est pas simplement une question de puissance brute, mais bien de raffinement, de sécurité et d’une intégration plus naturelle de l’IA dans nos interactions et nos outils.

Gemini 2.5 Pro : une puissance qui défie les attentes et redéfinit l’excellence

Lorsque Google a annoncé Gemini 2.5 Pro en mars, le monde de la technologie a retenu son souffle. Ce n’était pas un simple rafraîchissement de version, mais une véritable refonte des capacités, propulsant ce modèle au rang de leader mondial. Au-delà des chiffres impressionnants sur les benchmarks académiques, ce qui frappe le plus, c’est sa performance dans des domaines concrets. Imaginez un modèle qui non seulement excelle dans les tests théoriques, mais qui devient aussi la référence absolue dans des classements pratiques comme WebDev Arena et LMArena. C’est un peu comme si un athlète olympique, après avoir battu des records sur piste, se mettait à dominer aussi les marathons et les triathlons.

L’une des preuves les plus éloquentes de la supériorité de Gemini 2.5 Pro réside dans son ascension fulgurante au sommet du classement de codage WebDev Arena, atteignant un score ELO de 1 415. Pour ceux qui évoluent dans le monde du développement, ce chiffre parle de lui-même : il signifie une capacité inégalée à générer du code propre, efficace et pertinent pour les applications web les plus complexes. C’est un atout inestimable pour les développeurs qui cherchent à innover et à créer des expériences utilisateurs toujours plus riches et interactives. Mais l’excellence de 2.5 Pro ne s’arrête pas là. Sa domination dans les classements de LMArena, qui évaluent les préférences humaines dans diverses dimensions, démontre une compréhension nuancée des interactions et une capacité à produire des résultats qui résonnent véritablement avec les attentes des utilisateurs.

La fenêtre contextuelle d’un million de jetons de Gemini 2.5 Pro est une prouesse technique qui ouvre des possibilités quasi illimitées. Pensez à un esprit capable de saisir l’intégralité d’un roman, d’une thèse complexe, ou même d’un film entier sans perdre le fil. C’est précisément ce que cette fenêtre contextuelle permet. Elle dote le modèle d’une capacité de compréhension de contextes longs et de vidéos sans précédent, lui permettant de traiter d’énormes quantités d’informations simultanément. Cela se traduit par une cohérence et une pertinence accrues dans les réponses, que ce soit pour résumer des documents volumineux, analyser des séquences vidéo complexes ou simplement maintenir une conversation naturelle et fluide sur de longues périodes.

Et ce n’est pas tout. L’intégration de LearnLM, la gamme de modèles de Google élaborée en collaboration avec des experts en éducation, a transformé Gemini 2.5 Pro en un véritable modèle d’apprentissage de référence. Il n’est plus seulement question de fournir des informations, mais de les présenter de manière pédagogique et efficace. Des comparaisons directes ont révélé que les enseignants et les experts préféraient Gemini 2.5 Pro à d’autres modèles dans divers scénarios d’apprentissage.

Plus impressionnant encore, il a surpassé les meilleurs modèles sur chacun des cinq principes de la science de l’apprentissage utilisés pour concevoir des systèmes d’IA. Cela signifie que 2.5 Pro ne se contente pas de « savoir » ; il « enseigne » de manière optimisée, s’adaptant aux besoins spécifiques de l’apprenant, facilitant la compréhension et la rétention des connaissances. C’est un véritable compagnon pour l’apprentissage, capable d’expliquer des concepts complexes, de fournir des exemples pertinents et de s’adapter au rythme de chacun.

Deep Think : quand l’IA pense profondément pour résoudre l’irrésoluble avec Gemini

L’une des innovations les plus intrigantes et prometteuses annoncées pour Gemini 2.5 Pro est sans aucun doute le mode de raisonnement expérimental et amélioré baptisé Deep Think. Ce n’est pas juste une petite amélioration ; c’est une exploration audacieuse des frontières de la capacité de réflexion de l’IA. Deep Think utilise de nouvelles techniques de recherche qui permettent au modèle de considérer plusieurs hypothèses avant de formuler une réponse. Imaginez un détective qui, face à une énigme complexe, ne se contente pas d’une seule piste, mais explore toutes les possibilités, évalue les probabilités et affine ses conclusions. C’est cette approche méthodique et approfondie que Deep Think apporte à Gemini 2.5 Pro.

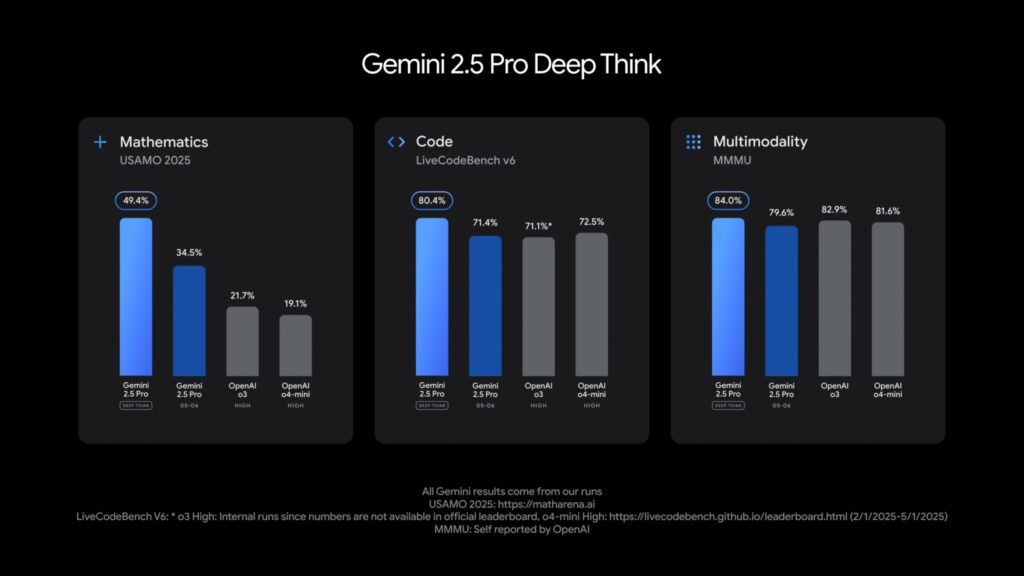

Les résultats préliminaires de Deep Think sont tout simplement stupéfiants, particulièrement dans les domaines qui exigent une logique implacable et une capacité de résolution de problèmes avancée. Prenez par exemple le 2025 USAMO (United States of America Mathematical Olympiad), l’un des tests mathématiques les plus exigeants au monde. Deep Think 2.5 Pro y obtient un score impressionnant, démontrant sa maîtrise des concepts mathématiques complexes et sa capacité à naviguer à travers des problèmes ardus avec une précision remarquable. C’est une avancée significative, car les mathématiques, avec leur structure rigoureuse et leurs exigences de raisonnement pas à pas, ont toujours été un défi de taille pour les intelligences artificielles.

De même, dans le domaine du codage de compétition, Deep Think se positionne en leader. Il caracole en tête du classement LiveCodeBench, un test réputé pour sa difficulté et sa capacité à séparer les meilleurs des bons développeurs. Cela signifie que le modèle est capable de générer du code non seulement fonctionnel, mais aussi optimisé, élégant et capable de résoudre des problèmes algorithmiques complexes, un talent rare même chez les développeurs humains expérimentés. Cette performance est cruciale pour l’avenir de la programmation assistée par l’IA, ouvrant la voie à des outils qui pourront non seulement aider à écrire du code, mais aussi à concevoir des architectures logicielles sophistiquées et à résoudre des bugs complexes.

Enfin, la performance de Deep Think 2.5 Pro avec un score de 84,0 % au MMMU (Multimodal Multitask Understanding), qui teste le raisonnement multimodal, souligne sa capacité à intégrer et à raisonner sur des informations provenant de différentes modalités, qu’il s’agisse de texte, d’images ou d’audio. C’est une compétence essentielle pour une IA qui se veut véritablement intelligente, car le monde réel est intrinsèquement multimodal. La capacité à faire des liens entre des informations de natures différentes est un signe distinctif d’une intelligence avancée.

Flash 2.5 : L’alliance de la vitesse et de l’efficacité pour une IA aaccessible

Si Gemini 2.5 Pro incarne la puissance et la profondeur de raisonnement, Flash 2.5 se positionne comme le champion de la vitesse et du faible coût. C’est le modèle optimisé pour les applications où la réactivité est primordiale et où les ressources doivent être utilisées avec parcimonie. Imaginez une version allégée, mais non moins performante, capable de répondre instantanément à vos requêtes sans sacrifier la qualité. C’est précisément la promesse de Flash 2.5, et les dernières mises à jour le rendent encore plus impressionnant.

Les améliorations apportées à Flash 2.5 sont significatives. Il a été optimisé sur des benchmarks clés en matière de raisonnement, de multimodalité, de code et de contexte long. Cela signifie qu’il est devenu plus intelligent et plus polyvalent, tout en conservant son avantage principal : l’efficacité. Les évaluations internes de Google montrent que Flash 2.5 utilise 20 à 30 % de jetons en moins, ce qui se traduit directement par une réduction des coûts et une augmentation de la vitesse d’exécution. Pour les développeurs et les entreprises qui gèrent des applications à grande échelle, cette optimisation est un facteur de différenciation majeur. C’est la possibilité d’offrir des expériences IA fluides et réactives sans faire exploser les budgets.

L’accès à Flash 2.5 est également simplifié. Il est désormais disponible pour tous dans l’application Gemini, rendant cette technologie de pointe accessible à un public plus large. Pour les développeurs, la version mise à jour sera généralement disponible dans Google AI Studio et dans Vertex AI pour les entreprises début juin, suivie de près par 2.5 Pro.

Des fonctionnalités révolutionnaires : Gemini 2.5 au service de l’humain

Les avancées de Gemini 2.5 ne se limitent pas à l’amélioration des performances brutes des modèles. Google a également introduit des fonctionnalités novatrices qui visent à rendre l’interaction avec l’IA plus naturelle, plus sûre et plus efficace. Ces innovations sont la preuve d’une vision centrée sur l’utilisateur, où la technologie s’adapte aux besoins humains plutôt que l’inverse.

Une expérience conversationnelle réinventée avec la sortie Audio Native et l’API Live de Gemini

Imaginez une conversation avec une IA qui ne se contente pas de comprendre vos mots, mais aussi le ton de votre voix, vos émotions, et qui répond avec une intonation naturelle et expressive. C’est précisément ce que permet l’introduction d’une version préliminaire du dialogue d’entrée audiovisuelle et de sortie audio native dans l’API Live. Cette avancée ouvre la voie à des expériences conversationnelles plus immersives et intuitives. Vous pouvez désormais créer des dialogues où Gemini non seulement parle, mais le fait avec un ton, un accent et un style de parole que vous contrôlez. Envie d’une histoire racontée avec une voix théâtrale ? Gemini peut le faire.

Cette nouvelle capacité est enrichie par des fonctionnalités préliminaires qui révolutionnent l’interaction :

- Dialogue affectif : Le modèle détecte l’émotion dans la voix de l’utilisateur et adapte sa réponse en conséquence. Cela ouvre des portes à des applications de bien-être, de support client empathique ou même à des jeux interactifs où l’IA peut réagir à l’humeur du joueur.

- Audio proactif : Gemini peut ignorer les conversations de fond et savoir quand il est pertinent de répondre. Finies les interruptions intempestives ou les confusions ; l’IA comprend le contexte et interagit de manière plus intelligente et moins intrusive.

- Réflexion dans l’API Live : Le modèle exploite les capacités de raisonnement de Gemini pour prendre en charge des tâches plus complexes en temps réel. Cela signifie des conversations plus profondes, où l’IA peut vous aider à résoudre des problèmes complexes en direct, en puisant dans ses vastes connaissances et ses capacités de déduction.

L’IA aux commandes : L’utilisation de l’ordinateur via Project Mariner

Le Project Mariner est une initiative ambitieuse qui vise à doter les modèles d’IA de la capacité d’interagir directement avec les ordinateurs, ouvrant des perspectives jusqu’alors inexplorées. L’intégration de ces fonctionnalités informatiques dans l’API Gemini et Vertex AI est une véritable révolution. Imaginez une IA capable non seulement de comprendre vos requêtes, mais aussi d’exécuter des actions sur votre ordinateur, de naviguer sur le web, d’utiliser des logiciels ou même d’automatiser des tâches complexes. Des entreprises de premier plan comme Automation Anywhere, UiPath, Browserbase, Autotab, The Interaction Company et Cartwheel explorent déjà le potentiel de cette technologie.

Une sécurité renforcée : protéger l’IA des menaces croissantes

Avec la sophistication croissante des modèles d’IA, les défis en matière de sécurité augmentent également. Google a pris cette question très au sérieux et a considérablement renforcé la protection contre les menaces de sécurité, notamment les injections rapides indirectes. C’est un type d’attaque où des instructions malveillantes sont insérées dans les données que le modèle d’IA récupère, le poussant à exécuter des actions non désirées ou à générer des contenus inappropriés.

La nouvelle approche de sécurité de Google a permis d’augmenter significativement le taux de protection de Gemini contre ces attaques, faisant de Gemini 2.5 la famille de modèles la plus sécurisée à ce jour. Cet engagement envers la sécurité est crucial pour garantir la confiance des utilisateurs et des entreprises dans l’adoption de l’IA. Pour en savoir plus sur les efforts de Google en matière de sécurité, de responsabilité et de sûreté, ainsi que sur les avancées dans les mesures de protection de Gemini, le blog Google DeepMind offre des informations détaillées. C’est un rappel essentiel que l’innovation doit toujours aller de pair avec une vigilance constante et une responsabilité éthique irréprochable. La sécurité n’est pas une option, mais un pilier fondamental de l’IA de nouvelle génération.

Une expérience de développement améliorée : transparence et contrôle accrus

Google ne se contente pas d’améliorer les modèles ; ils investissent massivement dans l’expérience des développeurs. Parce qu’une IA puissante n’est vraiment utile que si les outils pour l’exploiter sont intuitifs et efficaces. Les dernières mises à jour de l’API Gemini et de Vertex AI témoignent de cet engagement, en offrant plus de transparence, de contrôle et de flexibilité.

Résumés de réflexions : comprendre la logique de Gemini

L’une des nouveautés les plus appréciées par les développeurs est l’intégration des synthèses analytiques ou « résumés de réflexions » dans Gemini 2.5 Pro et Flash. Jusqu’à présent, le processus de raisonnement interne d’un modèle d’IA pouvait ressembler à une boîte noire. Il formulait une réponse, mais la manière dont il y parvenait restait opaque. Désormais, ces synthèses reprennent les idées brutes du modèle et les organisent dans un format clair, avec des en-têtes, des détails clés et des informations sur les actions du modèle, comme l’utilisation des outils.

Budgets de réflexion : maîtrise des coûts et de la latence

Introduits initialement avec Flash 2.5 pour optimiser le rapport entre latence et qualité, les budgets de réflexion sont désormais étendus à Flash 2.5 Pro. Cette fonctionnalité offre aux développeurs un contrôle accru des coûts. Concrètement, vous pouvez contrôler le nombre de jetons qu’un modèle utilise pour « réfléchir » avant de formuler une réponse. Vous avez même la possibilité de désactiver complètement ses capacités de réflexion pour les cas où une réponse rapide prime sur une analyse approfondie.

Prise en charge MCP : une plus grande interopérabilité

Enfin, Google a ajouté la prise en charge native du SDK pour les définitions du protocole MCP (Model Context Protocol) dans l’API Gemini. Le protocole MCP est conçu pour faciliter l’intégration des modèles d’IA avec les outils open source. C’est une démarche essentielle vers une plus grande interopérabilité et une collaboration accrue au sein de l’écosystème de l’IA. En facilitant l’accès et l’intégration avec une multitude d’outils tiers, Google encourage la création d’applications agentiques plus sophistiquées et diversifiées.

Le futur de l’IA : un engagement continu vers l’innovation et la responsabilité

Les récentes annonces concernant Gemini 2.5 ne sont pas une fin en soi, mais une étape cruciale dans un voyage continu d’innovation et d’amélioration. Chaque avancée dans les modèles, chaque nouvelle fonctionnalité, chaque renforcement de la sécurité est le fruit d’un travail acharné et d’un investissement colossal de la part des équipes Google. L’objectif est clair : rendre ces technologies toujours plus performantes, plus efficaces, et les diffuser de manière sûre et responsable.

L’intelligence artificielle est un domaine en constante effervescence, où chaque jour apporte son lot de découvertes et de défis. Google s’engage à repousser les limites de la recherche fondamentale, à explorer de nouvelles approches, et à affiner constamment les capacités de Gemini. C’est une quête passionnante qui promet de transformer encore davantage notre manière de vivre, de travailler et d’apprendre. L’avenir de l’IA est entre les mains de ceux qui osent innover, tout en gardant à l’esprit l’importance de l’éthique et de la sécurité. Les progrès remarquables dont nous avons été témoins ne sont qu’un aperçu de ce qui nous attend. L’innovation continue, nourrie par les retours des développeurs et les avancées de la recherche, promet un avenir où l’IA sera un partenaire toujours plus intelligent, intuitif et bénéfique pour l’humanité. L’enthousiasme est palpable, et il y a fort à parier que de nouvelles informations passionnantes ne tarderont pas à émerger de cette aventure sans fin.

Notre équipe, passionnée par les dernières avancées technologiques, est à même de transformer ces concepts complexes en solutions concrètes et performantes pour votre entreprise. Nous comprenons les enjeux d’une intégration réussie de l’IA, de la conception à la mise en œuvre, en passant par l’optimisation des coûts et la sécurisation de vos données. Ne manquez pas l’opportunité de révolutionner votre activité. Contactez Numericoach dès aujourd’hui pour discuter de votre projet et découvrir comment l’intégration intelligente des modèles Gemini peut devenir un véritable catalyseur de croissance et d’innovation pour votre entreprise. L’avenir est à portée de main, et nous sommes là pour vous aider à le saisir !

- Articles connexes

- Plus de l'auteur

Sheets

Sheets  Agenda

Agenda  Forms

Forms  Apps Script

Apps Script  Gmail

Gmail  Chat

Chat  Meet

Meet  Contacts

Contacts  Chrome

Chrome  Sites

Sites  Looker Studio

Looker Studio  Slides

Slides  Docs

Docs  Drive

Drive  AppSheet

AppSheet  Admin Workspace

Admin Workspace

Android

Android  Chromebook

Chromebook  Equipements Google

Equipements Google  Google Cloud Platform

Google Cloud Platform  Google Photos

Google Photos  Maps

Maps  Youtube

Youtube